KI in der Psychotherapie - Chancen und Herausforderungen im Lichte des EU AI Acts

Die rasante Entwicklung der Künstlichen Intelligenz (KI) hat weitreichende Auswirkungen auf verschiedenste Bereiche unserer Gesellschaft, so auch auf das Gesundheitswesen und die Psychotherapie. Während KI-basierte Systeme vielversprechende Möglichkeiten zur Verbesserung der Versorgungsqualität und Effizienz bieten, ergeben sich gleichzeitig neue ethische, rechtliche und praktische Herausforderungen. Mit dem EU AI Act hat die Europäische Union einen rechtlichen Rahmen geschaffen, um den Einsatz von KI zu regulieren und die Rechte und Interessen der Bürger zu schützen. Dieser Artikel beleuchtet die Chancen und Herausforderungen von KI in der Psychotherapie unter Berücksichtigung der Vorgaben des EU AI Acts und diskutiert die Auswirkungen auf die psychotherapeutische Praxis.

Der EU AI Act und seine Relevanz für die Psychotherapie

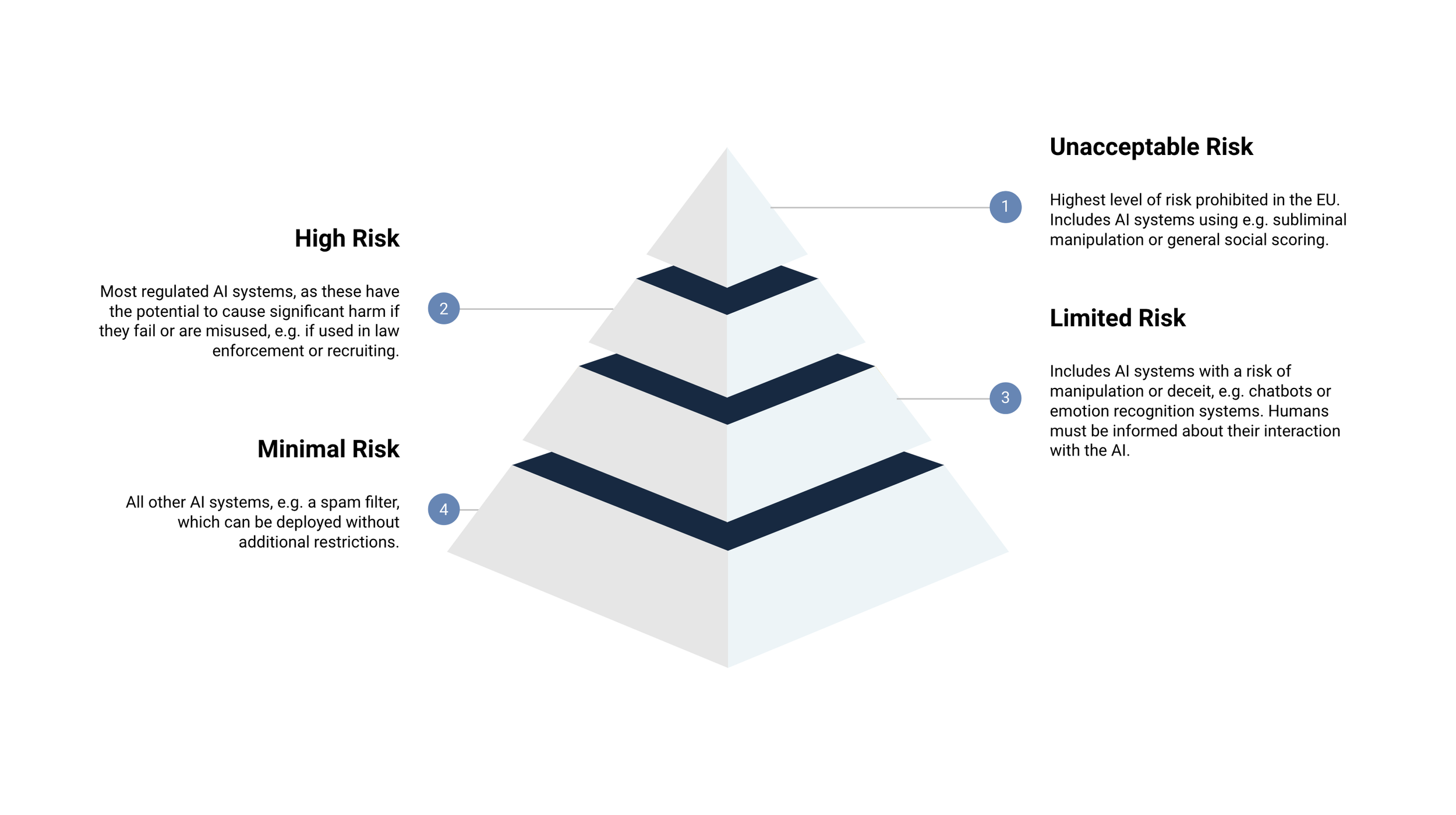

Der EU AI Act ist ein Gesetzesvorschlag der Europäischen Kommission, der darauf abzielt, einen harmonisierten Rechtsrahmen für die Entwicklung, Vermarktung und Nutzung von KI-Systemen in der EU zu schaffen (Europäische Kommission, 2021). Das Gesetz unterscheidet zwischen KI-Anwendungen mit unterschiedlichen Risikoniveaus und legt entsprechende Anforderungen und Verpflichtungen fest:

Übersicht

Unzulässiges Risiko

Beschreibung: Höchstes Risikoniveau, das in der EU verboten ist.

Beispiele: KI-Systeme, die z. B. subliminale Manipulation, Ausnutzung von Schwachstellen, biometrische Kategorisierung anhand sensibler Merkmale, allgemeine soziale Bewertung, Echtzeit-Fernidentifizierung in öffentlichen Räumen, Beurteilung des emotionalen Zustands am Arbeitsplatz oder in der Bildung, prädiktive Polizeiarbeit oder ungezieltes Scraping von Gesichtsbildern nutzen.

Hohes Risiko

Beschreibung: Am stärksten regulierte KI-Systeme, da sie potenziell erheblichen Schaden anrichten können, wenn sie versagen oder missbraucht werden.

Beispiele: KI-Systeme in Sicherheitskomponenten regulierter Produkte (z. B. Medizinprodukte, Fahrzeuge) oder eigenständige KI-Systeme in spezifischen Bereichen wie biometrische Systeme, kritische Infrastruktur, Bildung und Berufsbildung, Beschäftigung und Arbeitnehmerführung, Zugang zu wesentlichen privaten und öffentlichen Diensten und Leistungen, Strafverfolgung, Migration, Asyl und Grenzschutz sowie Rechtspflege und demokratische Prozesse.

Begrenztes Risiko

Beschreibung: KI-Systeme mit einem Risiko der Manipulation oder Täuschung.

Beispiele: Chatbots oder Systeme zur Emotionserkennung. Menschen müssen über ihre Interaktion mit der KI informiert werden.

Minimales Risiko

Beschreibung: Alle anderen KI-Systeme, die ohne zusätzliche Einschränkungen eingesetzt werden können.

Beispiele: Spamfilter.

Quelle: https://www.trail-ml.com/blog/eu-ai-act-how-risk-is-classified

Für die Psychotherapie sind insbesondere KI-Systeme relevant, die in die Kategorie "hohes Risiko" fallen, da sie die Gesundheit, Sicherheit und Grundrechte von Personen beeinträchtigen können. Dazu gehören beispielsweise KI-gestützte Diagnosesysteme, Chatbots zur Therapieunterstützung oder Algorithmen zur Vorhersage von Behandlungsergebnissen. Diese Systeme unterliegen strengen Anforderungen an Datenschutz, Transparenz, Nachvollziehbarkeit und menschliche Aufsicht.

Behandlung von General Purpose AI (GPAI) im EU AI Act

Der EU AI Act unterscheidet bei GPAI-Systemen, wie z. B. von OpenAI oder Aleph Alpha, zwischen nicht-systemischem und systemischem Risiko, abhängig von der für das Training des Modells erforderlichen Rechenleistung. Während alle GPAI-Modelle Transparenzanforderungen erfüllen müssen, unterliegen systemisch riskante Modelle deutlich strengeren Verpflichtungen. GPAI-Entwickler müssen nachgelagerten Anbietern, die diese Modelle in Hochrisiko-Anwendungen einsetzen, relevante Informationen zur Verfügung stellen.

Öffentlich zugängliche Open-Source-Modelle können strengere Anforderungen vermeiden, wenn ihre Lizenz den Zugriff, die Nutzung, Änderung und Verbreitung des Modells und seiner Parameter erlaubt, solange kein Bezug zu Hochrisiko- oder verbotenen Anwendungen besteht und kein Manipulationsrisiko vorliegt.

Chancen von KI in der Psychotherapie

Unterstützung bei der Diagnostik durch Analyse großer Datenmengen und Erkennung komplexer Muster (Luxton, 2014)

Identifikation individueller Risikofaktoren und Prädiktoren für den Therapieerfolg

Erstellung maßgeschneiderter Behandlungspläne

Begleitung von Patienten durch Chatbots und virtuelle Assistenten zur Förderung von Adhärenz und Wirksamkeit (Fitzpatrick et al., 2017)

Effizienzsteigerung und Kostenreduktion durch Automatisierung administrativer Aufgaben und Optimierung von Ressourcen (Torous & Roberts, 2017)

Herausforderungen und Risiken von KI in der Psychotherapie

Gewährleistung von Datenschutz und Sicherheit sensibler Patienteninformationen (Luxton et al., 2016)

Ethische Fragen bezüglich Verantwortung und Haftung bei der Verwendung von KI-generierten Empfehlungen oder Entscheidungen (Grote & Berens, 2020)

Notwendigkeit der Letztentscheidung durch Therapeuten bei KI-Systemen mit hohem Risiko

Akzeptanz und Vertrauen der Patienten in KI-basierte Anwendungen (Schulze et al., 2019)

Transparenz und Aufklärung über Funktionsweise und Limitationen der Systeme

Auswirkungen des EU AI Acts auf die psychotherapeutische Praxis

Anpassung der Arbeitsabläufe und Prozesse an rechtliche Anforderungen des Gesetzes

Sicherstellung der Konformität verwendeter KI-Systeme mit Vorgaben zu Datenschutz, Transparenz, Nachvollziehbarkeit und menschlicher Aufsicht

Schulung des Teams und Entwicklung neuer Kompetenzen im Umgang mit KI-Technologie

Fortbildungen und Weiterbildungen zu technischen, ethischen und rechtlichen Aspekten von KI

Fazit und Ausblick

Der EU AI Act schafft einen wichtigen rechtlichen Rahmen für den Einsatz von KI in der Psychotherapie und trägt dazu bei, die Rechte und Interessen von Patienten zu schützen. Gleichzeitig ergeben sich durch das Gesetz neue Anforderungen und Herausforderungen für die psychotherapeutische Praxis. Therapeuten müssen sich mit den Vorgaben des EU AI Acts vertraut machen, ihre Arbeitsabläufe anpassen und neue Kompetenzen im Umgang mit KI-Systemen entwickeln. Nur so können die Chancen von KI in der Psychotherapie genutzt und die Risiken minimiert werden. Weitere Forschung ist notwendig, um die Auswirkungen des EU AI Acts auf die klinische Praxis zu untersuchen und Best Practices für den ethisch vertretbaren und rechtlich konformen Einsatz von KI zu entwickeln. Ein interdisziplinärer Dialog zwischen Psychotherapeuten, KI-Experten, Ethikern und Juristen ist unerlässlich, um die Zukunft der KI in der Psychotherapie im Sinne der Patienten zu gestalten.

Literaturverzeichnis:

Europäische Kommission. (2021). Vorschlag für eine Verordnung des Europäischen Parlaments und des Rates zur Festlegung harmonisierter Vorschriften für Künstliche Intelligenz (Artificial Intelligence Act) und zur Änderung bestimmter Rechtsakte der Union. URL: https://eur-lex.europa.eu/legal-content/DE/TXT/?qid=1623335154975&uri=CELEX%3A52021PC0206

Fitzpatrick, K. K., Darcy, A., & Vierhile, M. (2017). Delivering cognitive behavior therapy to young adults with symptoms of depression and anxiety using a fully automated conversational agent (Woebot): a randomized controlled trial. JMIR mental health, 4(2), e19.

Grote, T., & Berens, P. (2020). On the ethics of algorithmic decision-making in healthcare. Journal of medical ethics, 46(3), 205-211.

Luxton, D. D. (2014). Artificial intelligence in psychological practice: Current and future applications and implications. Professional Psychology: Research and Practice, 45(5), 332.

Luxton, D. D., June, J. D., & Kinn, J. T. (2016). Artificial intelligence and the future of psychotherapy. In Artificial Intelligence in Behavioral and Mental Health Care (pp. 195-216). Academic Press.

Schulze, J., Majewski, M., & Harrer, M. (2019). Das Vertrauen der Patienten in KI-Systeme gewinnen. MMW-Fortschritte der Medizin, 161(19), 50-54.

Torous, J., & Roberts, L. W. (2017). Needed innovation in digital health and smartphone applications for mental health: transparency and trust. JAMA psychiatry, 74(5), 437-438.